2024年9月,阿里云在业内引起广泛关注的通义千问正式发布了其第二代视觉语言模型Qwen2-VL。这一系列新模型不仅在技术上有了显著提升,还在应用范围和用户体验上做出了优化,标志着阿里云在视觉语言处理领域的又一重要突破。

1. Qwen2-VL的全新特性与改进

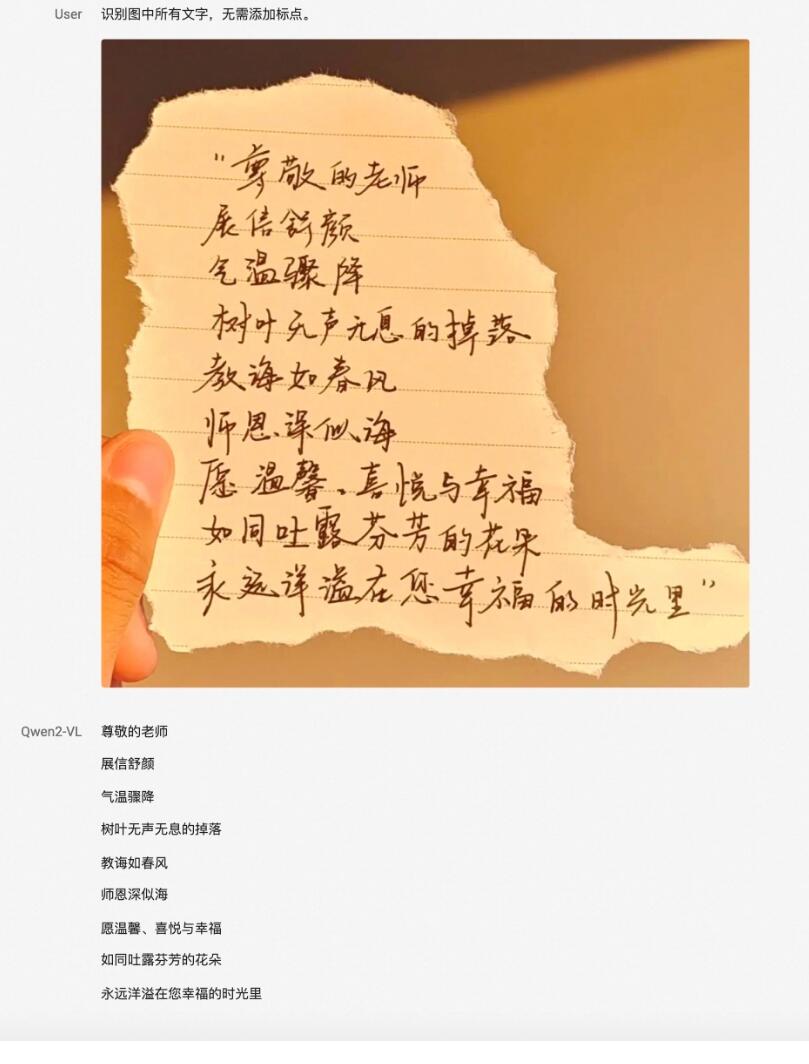

Qwen2-VL是对上一代模型的全面升级,其基础性能在多个方面都得到了显著提升。新模型不仅可以更精准地处理不同分辨率和长宽比的图像,而且在多个基准测试中表现优异。具体来说,Qwen2-VL在DocVQA、RealWorldQA和MTVQA等测试中创造了全球领先的成绩,显示出其在视觉理解方面的卓越能力。

一个显著的改进是Qwen2-VL能够理解超过20分钟的视频内容。这一能力使得模型在视频问答、对话生成和内容创作等应用场景中表现出色,大大拓宽了其实际应用的范围。

2. 技术创新与架构升级

Qwen2-VL继承了ViT(视觉变换器)与Qwen2的串联结构,但在架构上做出了重要的创新。首先,模型实现了对原生动态分辨率的全面支持。这意味着Qwen2-VL可以处理任意分辨率的图像输入,并将不同尺寸的图片转换为动态数量的tokens。这一设计模拟了人类视觉感知的自然方式,确保了模型输入与图像原始信息的高度一致性,从而提升了图像处理的灵活性和效率。

其次,Qwen2-VL引入了多模态旋转位置嵌入(M-ROPE)方法。传统的旋转位置嵌入技术仅能处理一维文本序列的信息,而M-ROPE方法则能够同时捕捉一维文本序列、二维视觉图像以及三维视频的位置信息。这一技术的引入使得Qwen2-VL在多模态数据处理和推理方面展现了强大的能力,有效地提升了模型对复杂数据的理解和建模能力。

3. Qwen2-VL的模型版本与开放

此次发布的Qwen2-VL系列包括多个版本,其中旗舰模型Qwen2-VL-72B的API已上线阿里云百炼平台。用户可以通过该平台直接调用API,享受模型强大的功能。

此外,通义千问团队以Apache 2.0协议开源了Qwen2-VL-2B和Qwen2-VL-7B两个模型版本。开源代码已集成到Hugging Face Transformers、vLLM等多个第三方框架中,开发者可以通过Hugging Face和魔搭ModelScope下载使用这些模型。同时,通义官网和通义App的主对话页面也支持直接使用这些开源模型,为广大开发者和用户提供了更多便捷的使用方式。