12月24日,清华大学智能产业研究院(AIR)正式发布一篇论文,介绍其最新的AI模型AutoDroid-V2.这一新技术以设备端的小型语言模型(SLM)为核心,通过脚本生成的方式,实现了移动设备自然语言控制的全新突破,相较传统依赖云端的大型语言模型(LLM)方法,在效率、隐私保护和资源消耗等方面表现尤为突出。

从背景到突破:模型开发的初衷

近年来,LLM和视觉语言模型(VLM)逐渐成为移动设备控制领域的重要工具,凭借自然语言命令,帮助用户解决复杂任务。然而,传统的“逐步 GUI 智能体”(Step-wise GUI agents)方法需要通过动态查询和反复交互完成操作。这种方法依赖云端计算,导致隐私风险增加、数据流量高企,以及用户体验受到延迟影响。此外,云端处理模式还带来了高昂的服务器成本,限制了大规模应用的普及。

为了克服这些限制,AutoDroid-V2引入了一种全新的解决方案:将任务转换为可一键执行的多步骤脚本,由设备端的小型语言模型独立处理。这不仅减少了交互频率和数据传输,还显著提高了任务完成的效率。

AutoDroid-V2 的技术核心与工作机制

离线阶段:构建高效文档

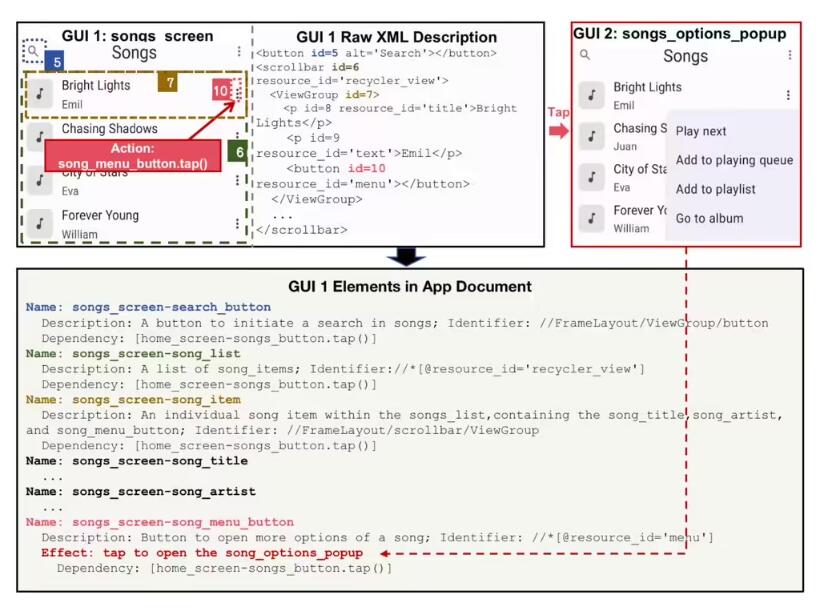

AutoDroid-V2通过离线分析应用程序的GUI结构,创建详尽的文档,包括GUI状态压缩、元素路径(XPath)生成以及依赖关系分析。这一过程为任务脚本生成提供了可靠的数据基础。

在线任务执行:脚本生成与执行

用户提交任务请求后,本地小型语言模型基于先前构建的文档快速生成多步骤脚本。这些脚本由特定领域的解释器执行,确保任务完成的高效与可靠。此外,由于脚本生成和执行均在设备端完成,数据隐私得到了最大程度的保障。

多模型兼容性

AutoDroid-V2在Llama3.2-3B、Qwen2.5-7B和Llama3.1-8B等多种模型上测试,显示出高度一致的表现,成功率在44.6%-54.4%之间,反向冗余比达90.5%-93.0%。

性能与实际应用

AutoDroid-V2在23款移动应用中完成了226项任务测试,与其他基准模型(如AutoDroid、SeeClick、CogAgent和Mind2Web)相比,任务完成率提高了10.5%-51.7%。资源消耗显著降低:输入和输出token的消耗分别减少至原来的1/43.5和1/5.8.推理延迟也仅为传统方法的1/5.7至1/13.4.

这些性能数据表明,AutoDroid-V2不仅能显著提高移动端自然语言控制的效率,还具备极高的实用价值,尤其是在隐私和资源敏感的应用场景中。