Meta已确认Hammerspace是其数据编排软件供应商,支持49152个Nvidia H100 GPU,分为两个相等的集群。

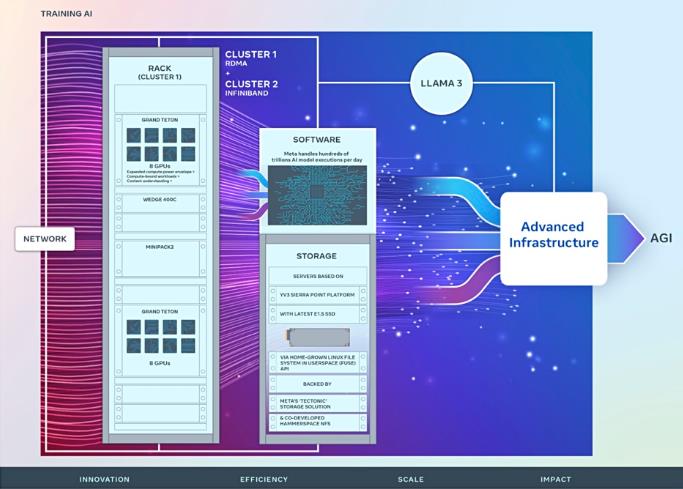

Facebook、Instgram和其他社交媒体平台的母公司表示,其“长期愿景是创建开放、负责任地构建的通用人工智能(AGI),让每个人都能从中受益。”博客作者表示:“我们宣布了两个24k GPU集群,这标志着对Meta人工智能未来的重大投资。我们正在分享硬件、网络、存储、设计、性能和软件的细节,帮助我们为各种人工智能工作负载提取高吞吐量和可靠性。”

几周来,Hammerspace一直在说,它有一个巨大的超规模人工智能客户,我们怀疑他是Meta,现在Meta已经描述了Hammerspace在两个Llama 3人工智能训练系统中的作用。

Meta的博客作者表示:“这些集群支持我们当前和下一代的人工智能模型,包括我们公开发布的LLM Llama 2的继任者Llama 3,以及GenAI和其他领域的人工智能研发。”

拥有16000个Nvidia A100 GPU的前身人工智能研究超级集群被用于构建Meta的第1代人工智能模型,并“继续在Llama和Llama 2的开发中发挥重要作用,以及用于计算机视觉、NLP和语音识别、图像生成甚至编码等应用的高级人工智能模型。”该集群使用纯存储闪存阵列和FlashBlade所有闪存阵列。

它们“支持比RSC支持的更大、更复杂的模型,并为GenAI产品开发和人工智能研究的进步铺平道路。”这里的规模是压倒性的,因为它们帮助处理“每天数万亿的人工智能模型执行”

这两个集群分别以24576个Nvidia H100 GPU开始。其中一个具有RDMA over RoCE 400 Gbps以太网系统,使用Arista 7800交换机和Wedge400和Minipack2 OCP机架交换机,而另一个具有Nvidia Quantum2 400 Gbps InfiniBand设置。

Meta的Grand Teton OCP硬件机箱容纳GPU,GPU依赖Meta的Structuretic分布式、闪存优化和EB级存储系统。

这是通过用户空间(FUSE)API中的元开发Linux文件系统访问的,用于AI模型数据需求和模型检查点。该博客称:“该解决方案使数千个GPU能够以同步的方式保存和加载检查点(这对任何存储解决方案来说都是一个挑战),同时还提供了数据加载所需的灵活、高通量的EB级存储。”

Meta已与Hammerspace合作“共同开发并实现并行网络文件系统(NFS)”部署以满足该AI集群的开发人员体验要求…Hammerspace使工程师能够使用数千个GPU对作业执行交互式调试,因为环境中的所有节点都可以立即访问代码更改。当配对在一起时,我们的构造分布式存储解决方案和Hammerspace的组合能够在不影响规模的情况下实现快速迭代速度。”

Structural和Hammerspace支持的存储部署都使用Meta的YV3 Sierra Point服务器,该服务器配备了最高容量的E1.s格式SSD。这些OCP服务器“经过定制,以实现每台服务器的吞吐量、机架数量减少和相关电源效率的正确平衡”以及容错。

Meta并没有就此止步。博客作者表示:“这一宣布是我们雄心勃勃的基础设施路线图中的一步。到2024年底,我们的目标是继续扩大我们的基础设施建设,其中将包括350000个NVIDIA H100 GPU,作为投资组合的一部分,其计算能力将相当于近600000个H100。”